Sociologue à l’Institut national de recherche en sciences et technologies du numérique (Inria), directeur scientifique du LaborIA

La simplicité artificielle : une promesse confuse

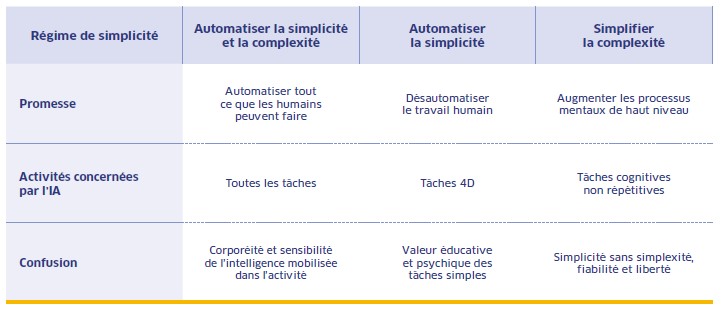

Le recours accru à l’intelligence artificielle promet une certaine domestication de la complexité : automatisation des tâches et augmentation des compétences simplifient indéniablement le travail. Cependant, les risques issus du simplisme technophile sont élevés, en matière de déresponsabilisation, d’affaissement de l’esprit critique, d’abaissement des capacités cognitives humaines.

Depuis la fin de l’année 2022, des applications de l’intelligence artificielle (IA) dite « générative » se répandent rapidement dans les vies domestiques et professionnelles. Ces applications apportent aux usagers une « simplicité artificielle » : des réponses rapides et assurées, à défaut d’être toujours fiables et pertinentes. Malgré ces limites, cette promesse de simplicité supplante progressivement les moteurs de recherche, dont l’offre – identifier des millions d’occurrences en quelques dixièmes de seconde – est déclassée. Ces usages réactivent le projet fondateur de l’IA de simuler l’ensemble des facultés cognitives humaines, dont les plus élémentaires s’avèrent paradoxalement les plus difficiles à émuler. Plutôt que de réaliser des tâches simples, l’IA semble davantage en mesure de simplifier la complexité, mais au prix de paniques morales.

L’intelligence artificielle, une hypothèse pas si simple

Le terme « intelligence artificielle » apparaît pour la première fois le 31 août 1955 dans un document de quelques pages, « A Proposal for the Dartmouth Summer Research Project on Artificial Intelligence ». Dès les premières lignes, l’hypothèse directrice est posée : « L’étude s’appuie sur la conjecture que tous les aspects de l’apprentissage ou toute autre caractéristique de l’intelligence peuvent en principe être décrits d’une manière si précise qu’une machine peut être fabriquée pour les simuler. » Participant aux premières semaines de ce séminaire, Herbert Simon, figure majeure de la science des organisations, s’intéresse à la manière dont les humains résolvent des problèmes mal structurés, dont la solution n’est pas « substantiellement rationnelle », un contexte décisionnel qualifié de « rationalité limitée ». Simon étudiait les procédures qui amènent à la solution la plus proche de l’optimum, tant dans les organisations humaines que dans les programmes informatiques. Et il promettait, en 1958, que « d’ici à vingt ans, les machines ser[aie]nt capables d’effectuer n’importe quel travail réalisable aujourd’hui par un humain 1 ».

De son côté, Hubert Dreyfus, professeur de philosophie à Berkeley, connu pour contester les présupposés de l’IA, lui reproche l’insuffisante prise en compte du rôle majeur du contexte (matériel, social, culturel) et du corps dans la cognition et l’action humaines. C’est pourquoi l’IA est particulièrement performante pour simuler des fonctions rationnelles « supérieures », naguère considérées comme exclusivement humaines, mais bute sur des dimensions plus animales de l’intelligence. Deux célèbres paradoxes appuient cette limite.

- Le paradoxe de Moravec : « Il est relativement facile de faire en sorte que les ordinateurs affichent des performances dignes d’un adulte lors de tests d’intelligence ou en jouant aux dames, et difficile, voire impossible, de leur donner les capacités d’un enfant d’un an en matière de perception et de mobilité. » Le roboticien Hans Moravec met ainsi en lumière la difficulté d’automatiser des propriétés sensori-motrices résultant du processus d’évolution adaptative.

- Le paradoxe de Polanyi : « Nous en savons plus que nous pouvons en dire… » Le philosophe Michael Polanyi exprime ainsi comment l’expertise se loge dans l’indicible de l’expérience au travail.

Ces deux paradoxes soulignent la nécessité de prendre à rebours la théorie classique qui définit l’IA comme une activité cognitive de résolution de problèmes. Or, au travail, nous disent Christophe Dejours et Isabelle Gernet, « l’intelligence du corps est toujours en avance sur sa symbolisation 2nbsp;». Cette expérience sensible de l’activité forme le « travail vivant ». « Ce sont généralement les changements ressentis par le corps (bruits, odeurs, chaleur) qui mobilisent la curiosité et la recherche de solution ». Dans sa tentative de décrire et de simuler l’intelligence humaine, la simplicité échappe donc à l’IA. À l’inverse, les processus mentaux les plus élevés sont plus accessibles. Mais qu’en est-il de l’IA dite « moderne » ?

Une complexité réhumanisante ?

Tandis que l’IA symbolique, qui a longtemps dominé la discipline, entreprend de répliquer les processus mentaux conscients, l’IA moderne (pourtant très ancienne…), dite « connexionniste », évacue toute modélisation explicite des caractéristiques des données. Cette méthode d’apprentissage propose au contraire le traitement le plus brut possible des entrées, optimisant la prédiction à partir d’énormes échantillons d’exemples. Ces algorithmes « implicites » démontrent leur supériorité nette pour les tâches de traitement de l’image, de la vidéo, du son, de la parole ainsi que la manipulation de texte qui, précisément, résistent à une description précise. Nul besoin désormais de formaliser préalablement une activité pour écrire les algorithmes, la machine extraira ses propres modèles dans les données.

Les premiers travaux sur le futur du travail au temps de l’automatisation avancée annoncent des impacts majeurs sur l’emploi. En 2013, Carl Benedikt Frey et Michael Osborne publient une étude quantitative retentissante : 47 % des emplois américains seraient menacés d’être automatisés d’ici dix à vingt ans 3. Les auteurs ont passé le descriptif de plus de 700 professions au filtre de trois « goulets d’étranglement à la frontière technologique », c’est-à-dire des limites techniques et sociales durables de la technologie :

- l’intelligence en trois dimensions (perception et manipulation) ;

- l’intelligence créative (avoir des idées nouvelles, les beaux-arts) ;

- l’intelligence sociale (négocier, persuader, comprendre et prendre soin des autres).

La prévalence de ces trois formes d’intelligence dans un métier réduit son exposition à l’IA. Si d’autres études aboutissent à des estimations bien moins impressionnantes, toutes convergent pour prédire l’automatisation prochaine et rapide des tâches répétitives, simples, peu qualifiées, à « faible valeur ajoutée ». Un an plus tard, le rapport de la mission Villani, qui dote la France d’une stratégie en IA, évoque « une chance historique de désautomatisation du travail humain : [l’IA] permet de développer des capacités proprement humaines 4 ».

À l’IA, les tâches dangereuses, ennuyeuses, bêtes et sales (4D : dangerous, dull, dirty, dumb), à l’humain, la complexité manuelle, créative et relationnelle.

Mais cette présentation de l’IA comme un outil libérateur des tâches dites « à faible valeur ajoutée » repose sur une vision simplificatrice et parfois trompeuse du travail. Derrière l’idée d’un partage optimal entre la machine, chargée des routines, et l’humain, concentré sur des activités « nobles », se cachent en effet plusieurs confusions. Ce qui est qualifié de répétitif ou de monotone par les décideurs peut en réalité constituer un espace d’apprentissage, de consolidation de savoir-faire, voire une ressource pour réguler l’intensité du travail. Réduisant la charge mentale, ces tâches procurent un sentiment de maîtrise sur l’activité qui contraste avec l’inconfort psychique de la complexité et de l’incertitude. De plus, elles ne sont pas isolées : elles s’articulent souvent avec des activités plus complexes, dont elles facilitent la fluidité et la maîtrise.

La complexité devient plus simple

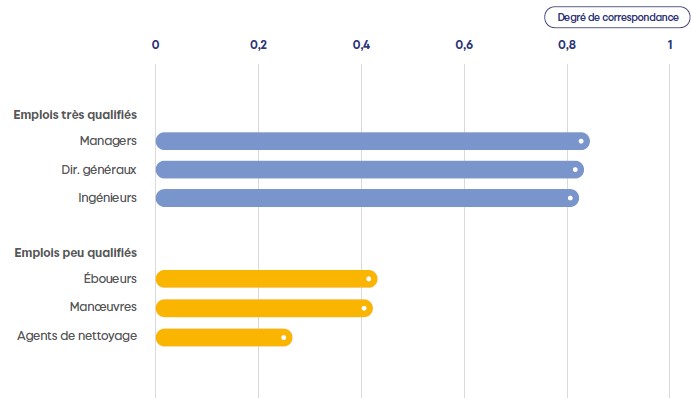

En 2023, un rapport de l’OCDE 5 croise l’état de l’art scientifique de l’IA avec la nomenclature de compétences des adultes issue de l’enquête PIAAC (Programme for the International Assessment of Adult Competencies). Il montre ainsi que l’IA a significativement progressé sur cinq compétences particulièrement mobilisées dans les tâches cognitives de haut niveau non répétitives : l’ordonnancement de l’information, la mémorisation, la vitesse de perception, la vitesse de structuration et la flexibilité de structuration. Ce sont alors les directeurs généraux, les ingénieurs et les managers qui seraient les plus exposés à l’IA !

Cette prédiction se confirme depuis l’avènement de l’IA générative, en particulier des large language models. Un sondage du Capgemini Research Institute 6 montre que si la rédaction d’e-mails (52 % des utilisateurs), la révision de textes (20 %) ou la traduction (16 %) relèvent d’une automatisation ciblée, des usages plus réflexifs apparaissent, comme le « brainstorming » (28 %), la veille technologique (28 %) ou la conception de supports pédagogiques (20 %). En février 2025, une analyse de plusieurs millions de conversations sur Claude.ai, menée par les équipes de recherche d’Anthropic, montre que les usages de l’IA s’organisent autour de deux grands schémas de collaboration 7.

L’automatisation : l’humain délègue à la machine l’exécution d’une tâche avec une implication réduite, qu’il s’agisse d’une exécution directe (directive) ou d’un suivi d’erreurs (boucle de rétroaction).

L’augmentation : l’IA soutient et enrichit l’activité humaine, par l’itération de tâche, l’apprentissage ou la validation.

Le schéma augmentatif est relativement plus fréquent (57 %) que l’automatisation (43 %). Dans ce contexte, l’IA n’est pas seulement un outil d’exécution, mais aussi un partenaire intellectuel capable de stimuler la pensée critique et l’apprentissage, en catalysant de nouvelles formes de coopération cognitive en vue de domestiquer la complexité. Séduisant, ce narratif est toutefois traversé par (au moins) trois paniques morales (des réactions collectives disproportionnées).

Une simplicité immorale ?

La première panique morale stigmatise l’opacité des raisonnements déployés par les réseaux neuronaux à la base du deep learning, qualifiés de « boîte noire ». Ce défaut d’explicabilité constitue aujourd’hui une limite majeure aux usages de l’IA, en particulier dans les activités critiques engageant l’intégrité physique (par exemple diagnostiquer une maladie) et/ou morale (par exemple juger un divorce) des humains. Le manque de traçabilité des raisonnements rend difficile pour les utilisateurs de comprendre comment (interprétabilité) et pourquoi (explicabilité) une décision a été produite. Si l’IA rend le raisonnement complexe plus simple et donc plus accessible, c’est au prix de son intelligibilité et, consécutivement, d’un risque de déresponsabilisation. L’IA produit une simplicité sans simplexité, néologisme qui désigne l’art de rendre simples, lisibles et compréhensibles les choses complexes.

La deuxième panique morale se concentre sur le manque de fiabilité de l’IA, en particulier générative, dont les erreurs sont qualifiées d’« hallucinations », des affirmations confiantes mais fausses qui contaminent les contenus générés par l’IA. En réponse, l’esprit critique est présenté comme une compétence cardinale. La chercheuse Elena Pasquinelli et ses collègues le définissent comme « l’ensemble des capacités et des critères qui permettent d’évaluer la qualité épistémique des informations disponibles et de doser de façon conséquente notre confiance en ces informations, en vue de prendre une décision, de se forger une opinion, d’accepter ou de rejeter une affirmation à bon escient 8nbsp;». Leurs travaux montrent que ce savoir-faire cognitif est rarement enseigné de manière explicite à l’école. Bien qu’il soit jugé prioritaire par les enseignants, ceux-ci considèrent que la méthode scientifique suffit à développer une pensée critique généralisable, postulat que ne partagent pas les auteurs, a fortiori quand de plus en plus d’individus s’informent principalement sur Internet et les réseaux sociaux via des algorithmes de recommandation. Dans le monde professionnel, cette compétence est jugée de façon ambivalente. Les recherches en sciences sociales montrent en effet que, souvent valorisé sur le principe, l’esprit critique se heurte aux pratiques organisationnelles dominées par un positivisme de l’action qui privilégie l’exécution de solutions validées à leur remise en question.

La troisième panique morale alerte sur un risque d’involution des capacités cognitives humaines, que l’usage systématique de l’IA dégraderait. L’offre de simplification contenue dans l’IA encouragerait la facilité qui consisterait à lui déléguer la quasi-totalité des raisonnements, réflexions et décisions. En juin 2025, une étude du MIT Media Lab 9 semble montrer que l’usage d’assistants IA comme ChatGPT entraîne un « délestage cognitif » : les utilisateurs sollicitaient moins leur cerveau que ceux travaillant seuls ou avec un moteur de recherche, et les travaux produits avec l’IA étaient aussi moins bien assimilés par leurs auteurs.

Dubitatif quant à la pertinence de ces études expérimentales pour trancher la valeur éducative de l’IA, le sociologue Bilel Benbouzid préfère considérer le sujet sous l’angle de l’éthique, s’interrogeant sur la nature de l’effort intellectuel légitime à fournir dans un contexte académique 10. En ce sens, l’auteur fait de l’écriture un acte fondateur de l’autonomie, bien plus qu’un acte éducatif, une « obligation morale envers soi-même ». Cette obligation consiste à cultiver les conditions de possibilité de sa liberté en développant les capacités de réflexion, de jugement et d’autodétermination. L’acte d’écrire n’est pas juste une compétence technique, mais un acte de formation éthique, un moment où l’individu exerce sa capacité à réfléchir sur ses engagements, à formuler des arguments et à construire un point de vue justifiable. Cela suppose une lente élaboration de soi à travers des pratiques intellectuelles rigoureuses, cultivée par l’effort de penser, de structurer ses idées et d’argumenter, des gestes rendus possibles par l’écriture. Déléguer l’écriture à une IA revient alors à renoncer à exercer les facultés qui rendent l’autonomie possible (délibération, critique, formulation d’un point de vue propre). Contre la facilité procurée par le recours à l’IA, Benbouzid valorise la difficulté intellectuelle comme formatrice et émancipatrice.

En définitive, la simplicité offerte par l’IA sacrifierait l’intelligibilité, la fiabilité et la liberté sur l’autel de l’efficacité et de la facilité. Dès lors, les enjeux d’une telle promesse vont au-delà des défis scientifiques et techniques pour interroger le lien traditionnellement établi entre technique, simplicité et progrès. Comme souvent, la simplicité conquise à court terme pourrait s’avérer régressive par la suite. En ce sens, au travail comme à l’école, la confusion générée par la simplicité artificielle convoque une réflexion collective en vue de distinguer le techniquement possible du socialement souhaitable. ?

Les emplois hautement qualifiés sont les plus exposés aux progrès de l’intelligence artificielle

Exposition à l’IA (degré de correspondance entre les capacités de l’IA et les tâches réalisées par les travailleurs dans différentes professions, min. = 0 ; max. = 1).

Source : OCDE.

LES TROIS CONFUSIONS DE LA SIMPLICITÉ ARTIFICIELLE

- Herbert Simon, The Shape of Automation for Men and Management, New York, Harper & Row, 1965, p. 40.

- Christophe Desjours, Isabelle Gernet, « Travail, subjectivité et confiance » ; Nouvelle Revue de psychosociologie, vol. 1, no 13, 2012, pp. 75-91. https://doi.org/10.3917/nrp.013.0075

- Carl Benedikt Frey, Michael Osborne, « The Future of Employment : How Susceptible are Jobs to Computerisation ? », Technological Forecasting and Social Change, vol. 11, no 4, issue C, 2013.

- Rapport de Cédric Villani au Premier ministre, Donner un sens à l’intelligence artificielle : pour une stratégie nationale et européenne, 2018.

- OCDE, Perspectives de l’emploi de l’OCDE 2023. Intelligence artificielle et marché du travail, Paris, OCDE, 2023. https://www.oecd.org/fr/publications/perspectives-de-l-emploi-de-l-ocde-2023_aae5dba0-fr/full-report/component-4.html#introduction-d5e198

- Capgemini Research Institute, « Why Consumers Love Generative AI », 2023. https://prod.ucwe.capgemini.com/wp-content/uploads/2023/05/Final-Web-Version-Report-Creative-Gen-AI.pdf

- Kunal Handa et al., « Which Economic Tasks are Performed with AI ? Evidence from Millions of Claude Conversations », 2025. https://assets.anthropic.com/m/2e23255f1e84ca97/original/Economic_Tasks_AI_Paper.pdf

- Elena Pasquinelli et al., Définir et éduquer à l’esprit critique, 2020.

- Nataliya Kosmyna et al., « Your Brain on ChatGPT : Accumulation of Cognitive Debt when Using an AI Assistant for Essay Writing Task », 2025. https://arxiv.org/pdf/2506.08872

- Bilel Benbouzid, « Écrire à l’université à l’heure des IA génératives : trouble dans l’auctorialité », AOC, 7 mai 2025. https://aoc.media/analyse/2025/05/06/ecrire-a-luniversite-a-lheure-des-ia-generatives-trouble-dans-lauctorialite-1-2/

http://www.constructif.fr/bibliotheque/2025-10/la-simplicite-artificielle-une-promesse-confuse.html?item_id=7986

© Constructif

Imprimer

Envoyer par mail

Réagir à l'article